Actualmente, la mayoría de los aficionados al cine utilizan viejas y costosas técnicas para lograr la captura de movimiento, pero un nueva app que usa el smartphone y ciertos dispositivos wearables, puede lograr esa captura de manera más fácil y barata.

Según se explica en una investigación presentada en el Simposio ACM 2024 sobre Software y Tecnología de Interfaz de Usuario, para crear personajes a través de imágenes generadas por computadora (CGI, por sus siglas en inglés) como Gollum en “El Señor de los Anillos” o los Na’vi en “Avatar”, los actores llevan trajes ajustados cubiertos de sensores mientras merodean por salas especializadas, para que después un ordenador capte los datos de los sensores y luego muestre los movimientos y las sutiles expresiones del actor.

Esa técnica se trata del actual estándar de oro de la captura de movimientos, pero su funcionamiento cuesta más de 100.000 dólares. Situación por la que muy pocos entusiastas del cine pueden acceder a ella.

Tomando en cuenta lo anterior, ingenieros de la Universidad Northwestern desarrollaron un nuevo sistema de captura de movimientos de cuerpo entero llamado MobilePoser, que, a diferencia de los equipos estándar actuales, no requiere salas especializadas, equipos caros, cámaras voluminosas ni un arsenal de sensores.

“Al eliminar la necesidad de infraestructura externa o hardware especializado, MobilePoser hace que la captura de movimiento sea realmente ubicua y accesible”, explicó a Metro Karan Ahuja, profesor de Informática en la Universidad Northwestern y líder del estudio.

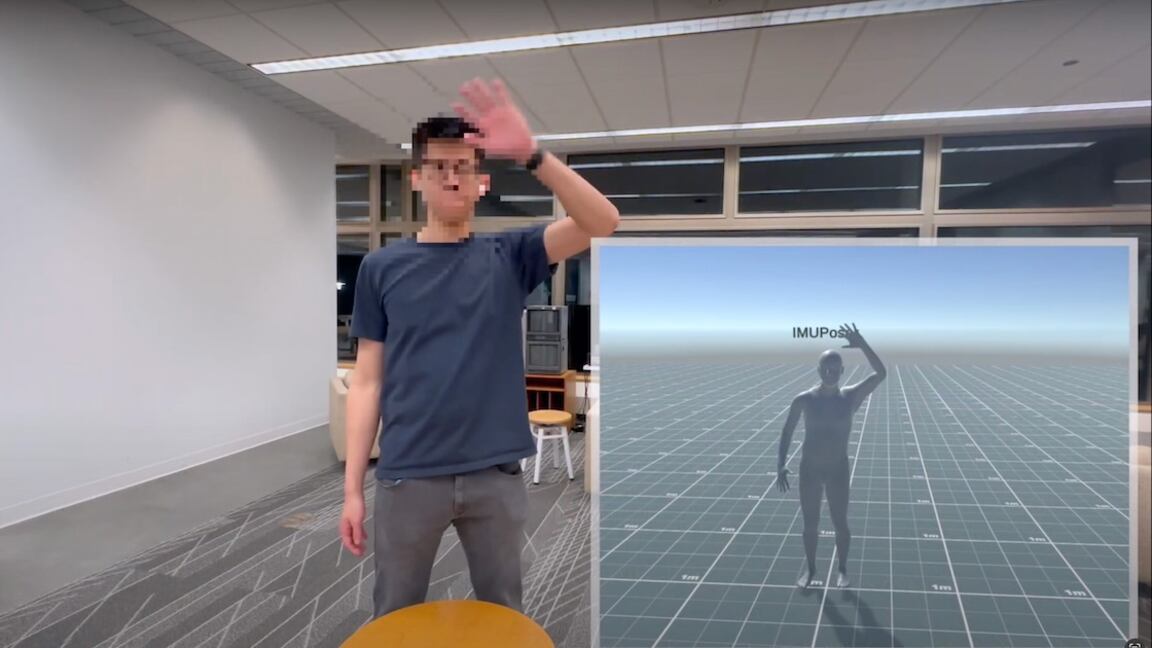

La aplicación de teléfono inteligente MobilePoser aprovecha los sensores ya integrados en dispositivos móviles de consumo, como teléfonos inteligentes, relojes inteligentes y auriculares inalámbricos. Mediante una combinación de datos de sensores, aprendizaje automático y física, la app rastrea con precisión y en tiempo real la postura de cuerpo entero de una persona y su traslación global en el espacio.

“Esta tecnología marca un salto significativo hacia la captura de movimiento móvil, haciendo más accesibles las experiencias inmersivas y abriendo puertas a aplicaciones innovadoras en diversos sectores”.

— Karan Ahuja, profesor de Informática en la Universidad Northwestern y líder del estudio.

Para lograr la captura de movimiento usando dispositivos eléctricos más comunes, el equipo de Ahuja recurrió a las unidades de medición inercial (IMU), un sistema que utiliza una combinación de sensores –acelerómetros, giroscopios y magnetómetros– para medir el movimiento y la orientación de un cuerpo y que ya están presentes en los teléfonos inteligentes y otros dispositivos; sin embargo, su fidelidad es demasiado baja para aplicaciones precisas de captura del movimiento.

Para mejorar el rendimiento de los IMU, el equipo de ingenieros añadió un algoritmo de inteligencia artificial (IA) multietapa creado a medida, que entrenaron utilizando un gran conjunto de datos públicos de mediciones IMU sintetizadas generadas a partir de datos de captura de movimiento de alta calidad.

El algoritmo de IA estima las posiciones y rotaciones de las articulaciones, la velocidad y dirección de la marcha y el contacto entre los pies del usuario y el suelo; después, MobilePoser utiliza un optimizador basado en la física para perfeccionar los movimientos previstos y garantizar que coincidan con los de la vida real.

Metro habló con Karan Ahuja para saber más de esta nueva tecnología.

Posibles usos de MobilePoser

- Podría ofrecer a los jugadores experiencias más inmersivas en las que los movimientos de todo el cuerpo de los jugadores se siguen con precisión utilizando sólo sus dispositivos cotidianos.

-En el ámbito de la salud y el bienestar, ofrece análisis de movimiento de nivel profesional para el seguimiento de la forma física y la rehabilitación, haciendo accesible una evaluación sofisticada del movimiento fuera de los entornos clínicos.

-En navegación en interiores, proporciona una localización humana precisa sin infraestructura externa.

5 preguntas a…

Karan Ahuja, profesor de Informática en la Universidad Northwestern y líder del estudio.

P: ¿Cómo surgió la idea de crear esta app?

–Mi tesis doctoral versaba sobre la digitalización de usuarios, así que llevábamos tiempo pensando en este campo. La idea surgió al detectar una laguna crítica en estas tecnologías desde el punto de vista de la accesibilidad centrada en el ser humano. Aunque la captura del movimiento ha evolucionado desde las salas especializadas hasta los sensores para llevar puestos, estas soluciones seguían siendo poco prácticas para el uso cotidiano. Por ejemplo, el estándar de oro -trajes MoCap de calidad comercial con marcadores que se llevan puestos y equipos de cámara externos, que cuestan decenas de miles de dólares- está fuera del alcance de muchos usuarios y sólo puede utilizarse en laboratorios profesionales, por ejemplo, en un estudio de cine.

Nos dimos cuenta de que la gente ya lleva sofisticados sensores IMU en muchos dispositivos de consumo, como teléfonos, relojes y auriculares. Esta red ubicua de sensores ofrecía la oportunidad de democratizar la tecnología de captura de movimiento. El reto de transformar estos dispositivos cotidianos en un sistema fiable de captura de movimiento impulsó el desarrollo de MobilePoser.

P: ¿Qué hace esta aplicación?

–MobilePoser representa un avance en la captura móvil del movimiento humano, transformando los dispositivos móviles cotidianos en un sofisticado sistema de seguimiento del movimiento. Reconstruye las posturas de cuerpo entero y la traslación global en tiempo real utilizando un subconjunto del teléfono, el reloj o los auriculares del usuario. Al eliminar la necesidad de infraestructura externa o hardware especializado, MobilePoser hace que la captura de movimiento sea realmente ubicua y accesible. También acerca su uso a aplicaciones como la telepresencia, la localización en interiores y el fitness, en las que la pose, la traslación y la movilidad son métricas importantes.

P: ¿Cómo captura el movimiento de todo el cuerpo en tiempo real?

–Emplea una novedosa arquitectura multietapa que combina el aprendizaje basado en datos con la optimización basada en la física. En primer lugar, una red neuronal profunda calcula las posiciones y rotaciones de las articulaciones a partir de entradas dispersas de la IMU, a lo que sigue un optimizador basado en la física que garantiza la plausibilidad biomecánica y la coherencia temporal. Este enfoque híbrido consigue un rendimiento en tiempo real a 60 Hz en dispositivos móviles, al tiempo que mantiene una precisión robusta incluso con una instrumentación mínima.

P: ¿Qué combinación de datos de sensores utiliza?

–Aplica un enfoque flexible de fusión de sensores que utiliza los datos de aceleración y orientación de las IMU de los dispositivos de consumo. La arquitectura adaptable admite cualquier combinación de dispositivos, desde un único teléfono en el bolsillo hasta varios dispositivos en distintas ubicaciones del cuerpo. El sistema se ajusta dinámicamente a los sensores disponibles manteniendo un rendimiento constante, lo que demuestra una notable resistencia a las distintas configuraciones de entrada.

P: ¿Qué planes tienen a futuro?

–Nuestra hoja de ruta se centra en el avance de la captura de movimiento móvil mediante técnicas de calibración cero con aprendizaje automático avanzado, la aplicación de la corrección de la deriva mediante la fusión de sensores multimodales y multidispositivo, y la ampliación a escenarios más exigentes del mundo real. También estamos trabajando en la integración con plataformas XR emergentes y en la creación de un ecosistema abierto para desarrolladores. El objetivo final es que el seguimiento preciso del movimiento sea tan omnipresente y fluido como lo es hoy la navegación GPS.